「CRI ADX LipSync」が実現する感動的なリップシンクー『ALTDEUS: Beyond Chronos』の魅力的なキャラクターの実在感について開発陣に訊く

2019年3月20日にMyDearestより発売されたVRミステリーアドベンチャーゲーム『東京クロノス』。熱狂的なファンの多い同作の300年後の世界を描くVRインタラクティブストーリーアクション『ALTDEUS: Beyond Chronos』が、2020年12月4日にリリースされました。現在はOculus Quest版とSteamVR版が発売されており、2021年4月にはPlayStation VR版の発売も予定されています。

VRゲームはその性質上、キャラクターが目の前にいるかのように描画されるため、アニメーションの機微や整合性が重要です。特に、キャラクターが喋る時の口の動きが正確であることは、キャラクターの実在感に大きな影響を与えます。本作の高品質なリップシンクを技術的に支えた「CRI ADX LipSync(以下、ADX LipSync)」について、本作のプログラマーである大川氏とサウンドエンジニアの田中氏に開発の裏側を伺いました。

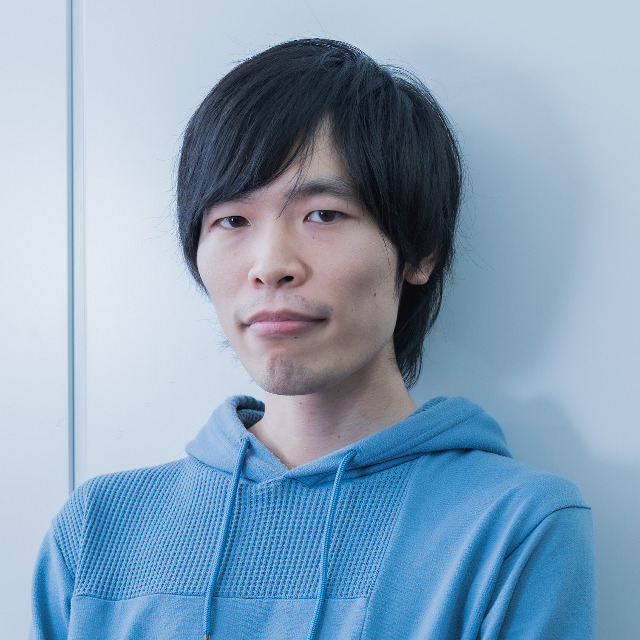

大川大輝氏(プログラマー)

『ALTDEUS: Beyond Chronos』のプログラマー。主にキャラクターアニメーション周りの基盤、特にモーションや表情などをリアルに動かすための実装を中心に担当した。

田中孝氏(サウンドエンジニア)

『ALTDEUS: Beyond Chronos』のサウンドエンジニア。「ADX2」の実装と、波形の加工やボイス編集などを担当。LipSync関連では、収録されたデータの管理とID等の検収も行っている。

「ADX2」にサウンドを一本化してサウンドの細かな調整に集中できた

――まずは『ALTDEUS: Beyond Chronos(以下、アルトデウスBC)』とはどのような作品なのか改めてご紹介いただけますか。

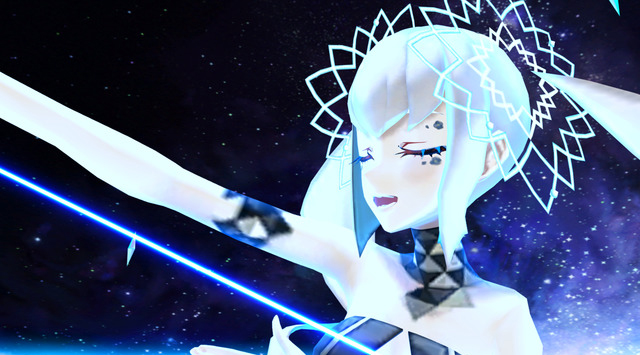

大川氏:前作「東京クロノス」から300年後の世界を舞台にしたVRインタラクティブストーリーアクションです。キャラクターが会話する「アドベンチャーパート」、400m級の巨大ロボットに乗って戦う「マシンアクションパート」、VR歌姫が歌唱を披露する「VRライブパート」の3つを軸としてストーリーを進めていきます。プレイ時間の想定は約20時間で、他のVRゲームよりも長い時間を遊んでいただける作品に仕上がりました。

――本作のサウンド開発におけるおおまかなスケジュールについて教えて下さい

大川氏:「『アルトデウスBC』の企画自体は、『東京クロノス』発売直後の2019年4月頃に立ち上がりました。その後、東京ゲームショウ2019で「プロジェクトメガリス」という名前で新作発表会をして、そこから開発が加速していきましたね。サウンド周りとしては、この時期に郡(郡陽介氏:同社サウンドディレクター)が楽曲イメージや曲数を策定し、キャスティングなども含めた調整を行っていました。

田中氏:ちなみに、私がMyDearestに入社したのは東京ゲームショウ2019の後でした。2020年2月頃まではシナリオが固まり切っていなかったため、この期間はBGMやSEなど一般的なアセット類の制作と並行しながら、「VR空間でどのように音を鳴らせばいいか?サウンド関係をすべて「CRI ADX2(以下、ADX2)」に統合した場合にどうなるか?」などの技術的な検証を重ねていました。アセットが揃って来たのは2020年5月頃で、そこからは怒涛のように作業に明け暮れていましたね。

――東京クロノスでも「ADX2」を使っていたかと思いますが、サウンド実装を「ADX2」に一本化したのは本作が初めてだったということでしょうか。

大川氏:正確には、前作はプラットフォームごとにサウンドミドルウェアが少しずつ違っていました。というのも、PS VR版では、PCやOculus Questで使っていたミドルウェアが使えなくなってしまったんです。当時はこれを補完するために「ADX2」を導入したのですが、本作では最初から「ADX2」に一本化して開発を進めることにしました。ハードウェアに関係なく常に使えるサウンドミドルウェアを使っておけば安心というところと、音の調整が一本化出来たほうが工数が減るだろうと考えたのが理由です。

田中氏:「ADX2」であればPS VRであってもOculus Questであっても同じ音が出せる、ということで実装面で楽ができます。これはただ楽をできるという意味ではなく、細かい調整に時間を使えるということですね。ハードごとに調整する手間を考えると、一度完璧なサウンドを作り込んでおいて、それをあらゆるプラットフォームに転用できるというのは大きな利点です。

――実装面に掛かるコストを削減し、細かな調整などの音作りに時間を割くことができたということですね。お二人にお伺いしたいのですが、本作において気に入っているサウンド演出などはありますでしょうか。

田中氏:インタラクティブミュージックの構成なども自分が考えていたので、音楽演出的に良い点もありますが、技術的な面では「ADX LipSync」によって口と音声のズレを軽減できた点はさらにゲームへの没入感を高められたと思っています。VRの場合、キャラクターを間近で見ることが多く、口の動きがズレているとおかしく感じてしまうので、そうした違和感をなくせる仕上がりになったので満足しています。キャラクターボイスは基本的にはリアルタイムでの3Dポジショニングを行っていますが、ジュリィ博士が自分の周りをウロウロしながら喋るシーンの位置による聴こえ方の変化などは焼き込みでやっていますし、他にも街中のガヤはクラウドファンディング応募者の音声を使ってみるなど、たくさんのサウンド技術が組み合わさって本作ならではの特徴が出せたかなと感じています。

大川氏:自分が基盤を作った部分でもあるので、VRライブパートが気に入っていますね。ノアというキャラクターが踊りながら歌うのですが、歌っている口の動きと音声がシンクしているので、眼前で歌ってくれている感が出せたかなと思います。

「ADX LipSync」はどんな魔法を使っているのか?

『アルトデウスBC』で感じた導入の容易さと可能性

――さて、ここからは本題の「ADX LipSync」についてお伺いします。まずは、採用に至った経緯を教えて下さい。

大川氏:前作はOVR Lip Syncを用いて実装をしていました。当時はリアルタイム変換が難しく、中間ファイルからアニメーションを生成する流れで実装を行っていたため、プラットフォームごとに修正の工数が発生していました。別のLipSyncを検討しようとしたときに、たまたま2019年10月に開催されたCRI・ミドルウェアのADX LipSyncセミナーに参加し、その後テストを兼ねて使ってみようということになりました。

田中氏:「ADX2」自体も使うことが確定していたので、組み合わせによって開発のコストが下がるのであれば良いのではないか、と期待してテストを始めましたね。

――「ADX LipSync」にはリアルタイム解析の「ADX LipSync Library」と事前解析の「ADX LipSync Tools」がありますが、今回はどちらを採用していますか?また、実装上の工夫を教えて下さい。

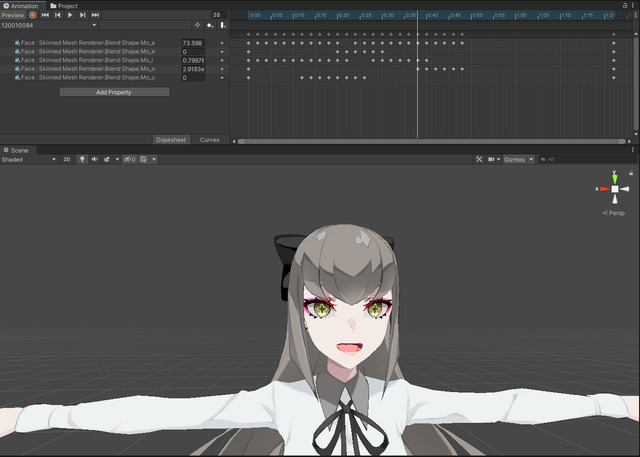

田中氏:「ADX LipSync Tools」で事前解析しています。今回は音声データが1言語で9222ファイルあり、これらをPythonを通じて自動的にADX LipSync Toolsにインポートし、wavファイルからcsvファイルを生成しています。音声データさえ正しいものが来れば、量が膨大であろうとも数十分の処理で終わります。

大川氏:wavからcsvに変換するのは1ボタンですし、csvから要素を抽出してUnityのアニメーションに適用するスクリプトも事前に組んでいたので、ほとんどオートマティックにアニメーション生成ができました。「ADX LipSync Tools」を使えば使い易い形式で母音のデータが出力されるので、そこも助かりましたね。『東京クロノス』の時はかなり手間を掛けてしまったのですが、今作では開発初期に組んだ仕組みを最後まで使い続けられたので、ワークフローに関してはかなり良くなったと感じています。リップシンク以前に、3Dモデルの段階でいかなる母音の数値が来た場合も破綻しないように作り込んでいたため、モデルが破綻するようなこともありませんでした。

田中氏:自分の作業は元波形の編集だけで、「ADX LipSync」に関しては何もしていない、というか何も出来ないんですけど。それでもあれだけ良いものが出来るんだ、というのは本当に感動しました。

――その意味では、周りの開発メンバーからリップシンクに関してポジティブな反応がありましたか?

田中氏:社内のデザイナーも「『アルトデウスBC』はキャラクターがちゃんと口パクしてるね」とその精度の高さを評価していました。普通のゲームだとぴったり合っていなくても良いのですが、VRの場合はそこがきっちりシンクすると体験がすごく良くなるので。まさに「ADX LipSync」さまさまでしたね。

大川氏:プレイヤーからの反応も良かったです。「ただ口が動いているだけではない」、きちんと話しているように見えていたというのはフィードバックとしていただけたので、VRゲームという特性も手伝って分かりやすく効果があったのかなと思っています。

――ちなみに、チェック周りはどのように行いましたか?

田中氏:そこはテストの段階で見てもらって、口の動きがおかしくないかは確認してもらいました。バグ報告で「音声が違います」ということはありましたが、それは単純にIDミスだったりもしますので、リップシンクに関しては音声さえ合っていればほぼ問題ありませんでした。

――CRI・ミドルウェアのサポートに関してはいかがでしたでしょうか。

田中氏:VR開発においては新しいことの連続であったため、正直マニュアルを見ても解決できないことはありました。ですが、日本語で質問ができて、そのレスポンスがすぐに返ってくる、というのは本当に助かりました。「ADX2」に関してはいろいろご質問させていただきましたが、ADX LipSyncについては正直ほとんど問題も質問もなかったので、本当にスムーズに導入できたし、社内外から高い評価を得ることができてよかったと思います。

――今後、サウンド的にチャレンジしたいことや、お二人の展望について教えて下さい。

大川氏:口の動きは今回でかなり良くなりましたので、次回作があれば舌の動きに挑戦してみたいと思っています。人間が喋る時は、ビジュアル的に舌も動くものだと思っているので、そこをしっかりと実装してみたいです。弊社は今後もキャラクターが出てきて物語をやるという作品を作り続けていきますので、いずれ実現を目指したいですね。

田中氏:リップシンクに関してはもう僕の方では良く出来ているなという感覚で、舌までは意識が回りませんでした。個人的には、「VR空間で、きちんとその場所から鳴っている感」を突き詰めたいと思います。ちょっと上から喋ってるとか、後方定位とか、まだまだやりようはあると思っています。現在は声を中心に考えて実装をしていましたが、今後は音楽や環境音も周りに配置するとさらにVRゲームならではの良さが体験してもらえるのではないかな、と思います。

――ありがとうございました。最後に、ADX LipSyncを導入検討する方に向けて、メッセージをお願いいたします。

大川氏:本作は日英の2言語で、VRゲームということもあって、出来る限り軽く作るというのが命題でした。対応する言語が増えると、アニメーションに変換した際に膨大なファイル数になってしまいます。「ADX LipSync Tools」であらかじめアニメーションを生成しておくだけでなく、「ADX LipSync Library」を用いてリアルタイム解析することも出来るという意味では、ゲームの用途に応じて様々な使い方ができる使いやすいツールだと感じています。

田中氏:とにかく導入が簡単だったということは伝えておきたいです!パラメータも書き換えられるところはありましたが、自分が操作したのは30fpsに調整したくらいでした。収録データを無加工でインポートしてこのクオリティなので、どんな魔法が使われているのかと感動しました。歌もので使えるというのも良かったので、気になっている方は是非試してみてください。

――ありがとうございました。

VRならではの演出とその物語性で高い評価を得ている『ALTDEUS: Beyond Chronos』。Oculusだけでなく他のVRプラットフォーム展開も進められている本作において、没入感を高めるサウンド・演出には「ADX2」そして「ADX LipSync」の技術が活用されていました。マルチプラットフォーム対応や高度なリップシンクなどに挑戦したいデベロッパーの方はぜひ導入を検討してみてはいかがでしょうか。

CRI ADX LipSyncは、ディープラーニングによる音声解析技術を活用し、音声データから自然な口パターンを自動生成する音声解析リップシンクミドルウェアです。ゲーム内の会話シーンやバーチャルキャラクターのライブ配信などで、セリフに合わせた自然な口の動きを生成します。詳しくは「音声解析リップシンクミドルウェア CRI ADX LipSync」をご覧ください。

CRI ADX LipSyncは、ディープラーニングによる音声解析技術を活用し、音声データから自然な口パターンを自動生成する音声解析リップシンクミドルウェアです。ゲーム内の会話シーンやバーチャルキャラクターのライブ配信などで、セリフに合わせた自然な口の動きを生成します。詳しくは「音声解析リップシンクミドルウェア CRI ADX LipSync」をご覧ください。