「当たり前のこと」をCGキャラクターが表現するには?

「THE IDOLM@STER MR ST@GE!!」でCRI ADX LipSyncが実現したスムーズなリップシンクについて開発者に訊く

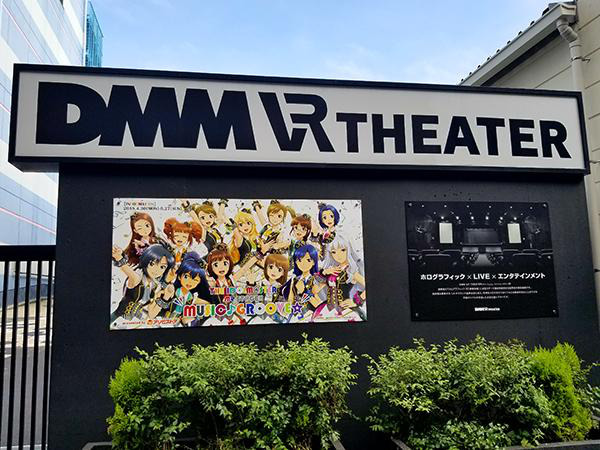

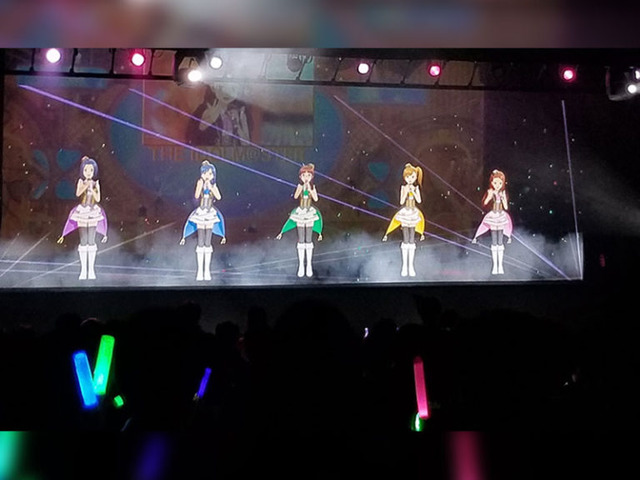

多くの“プロデューサー”を魅了する「THE IDOLM@STER」シリーズのアイドルたちが、ついに現実世界にやって来たーー2018年4月にDMM VR THEATERで行われたのち、2度に渡る再演が行われた「THE IDOLM@STER MR ST@GE!! MUSIC♪GROOVE☆ENCORE」は、ステージに立ったアイドルたちがリアルタイムに会話をしたり、歌や踊りを披露するなど、キャラクターの実在性が非常に高いイベントでした。

キャラクターの実在感を高めるために重要な技術のひとつが「リップシンク」です。言葉を発するとその通りに口が開くというのは人間にとって当たり前のことですが、CGキャラクターがこれを演じるためには高度なアニメーション制御の仕組みが必要となります。今回は2020年2月に行われた「THE IDOLM@STER MR ST@GE!! MUSIC♪GROOVE☆ENCORE」を題材として、高品質なリップシンクを提供する「CRI ADX LipSync(以下、ADX LipSync)」の実力を開発の中核メンバー3名に訊いていきます。

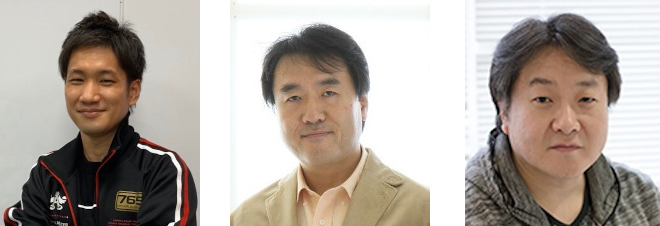

――まずはお名前と所属を教えて下さい。

勝股春樹氏:バンダイナムコエンターテインメント の勝股です。THE IDOLM@STER MR ST@GE!!のプロデューサーを担当しています。本日はよろしくお願いいたします。

佐々木直哉氏:バンダイナムコスタジオ エンジニアの佐々木です。「THE IDOLM@STER MR ST@GE!!」では、主に描画システムの開発を担当しています。

大曽根淳氏:バンダイナムコスタジオ MoCapプロデューサーの大曽根です。「BanaCAST」いう弊社のリアルタイムキャラクター アニメーションテクノロジーのプロデューサーでもあり、このプロジェクトにおいてはバンダイナムコスタジオ側の取りまとめを担当しています。

左から勝股氏、佐々木氏、大曽根氏

左から勝股氏、佐々木氏、大曽根氏

――大反響だったMRライブイベントである「THE IDOLM@STER MR ST@GE!!」について紹介をお願いします。

勝股 氏:「THE IDOLM@STER MR ST@GE!!」は、アイドルマスターシリーズに登場するアイドルたちの活動をを現実世界で味わうことのできるイベントです。ライブに限定することなく、リアルタイムに動くアイドルとインタラクティブに接することができるイベント全般をMR ST@GE!!と定義しています。出発点は2018年4月にDMM VR THEATERで行った「THE IDOLM@STER MR ST@GE!! MUSIC♪GROOVE☆」で、同年9月には「THE IDOLM@STER MR ST@GE!! MUSIC♪GROOVE☆2nd SEASON」を開催しました。

――今年2月には「THE IDOLM@STER MR ST@GE!! MUSIC♪GROOVE☆ENCORE」も開催していますが、昨今の情勢もあって一部は延期になったと聞いています。

勝股 氏:はい、3度目の開催となる「THE IDOLM@STER MR ST@GE!! MUSIC♪GROOVE☆ENCORE」では、残念ながら最後の3日間だけが中止となりました。MR ST@GE!!は765PRO ALLSTARSの単独公演で、ユニット曲を披露する他、1人のアイドルにフィーチャーする主演アイドル制を取っており、日替わりで主演アイドルがメインとなり、ソロ曲も披露します。MUSIC♪GROOBE☆を通して、一度も主演ができなかった星井美希で7月11日に生配信も行いました。

――星井美希の放送は9万人を超える来場者数だったとのことで、改めて注目度の高さが伺えます。ENCOREは再演という形ですが、1stや2ndと変わった点はありましたか。

勝股 氏:構成自体はあまり変えておらず、主演アイドルという制度も同じです。ユニット曲に関しては1stと2ndでやっていたものがメインで、ENCOREは数曲だけ新曲を追加しています。

大曽根 氏:驚く話かも知れませんが、メインで動いている技術側の人間は2~3名程度です。「THE IDOLM@STER MR ST@GE!!」ではメインのエンジニアは1~2名の体制で、主体的に動くメンバーは実はかなり少ないんです。

佐々木 氏:映像部分はモーションキャプチャ班と描画班に分かれておりますが、描画班も私を含めて2名で、普段は別のゲーム案件をメインとしながら、MRライブを行う時だけこちらのプロジェクトに参画するような体制を敷いています。私はもともとPS4版の『アイドルマスター プラチナスターズ』や『ステラステージ』の開発を担当しており、リアルタイムのライブでも描画部分はゲームの仕組みを用いているため、引き続きこのプロジェクトでも目に見える部分を担当しています。

勝股 氏:私の方からバンダイナムコスタジオ側に「こういうイベントをやりたいのでお願いします!」とお願いして。そこから各セクションから精鋭の皆さんが集まってくださり、プロジェクトが出来上がっていきます。すごくフレキシブルなチームだと思いますね。

大曽根 氏:主体的に動くのは数名ですが、少しずつスタジオのみんながいろいろなことを協力してくれていているんです。例えば衣装決めや何か絵が欲しいという場合はビジュアルアーティストが手伝ってくれたりとか……新しいエンターテイメントの話をすると、全員が前ノリで協力してくれるので、そういった部分では熱量があります。

――キャラクターの存在感やライブ感を出すためにこだわった部分を教えて下さい。

勝股 氏:とにかく、「アイドルがそこにいる!」と思って欲しいんです。CGや人形が動いている、ではダメで、さらにその先の表現を追い求めました。「人間がやっていることを当たり前にやって欲しい」という想いがありました。人間の動きとCGの差を極力少なくするためには、細かいところで嘘が出ないような滑らかな動きが絶対的に必要だったのです。

大曽根 氏:自分たちで言うことではないかも知れませんが、キャラクターのCGモデルのクオリティが圧倒的に高いんです。ですから、彼女たちを現実で見た時に違和感がないように……私自身もCEDEC 2018で「次元の壁を一緒に越えよう」というお話をしたのですが、次元の境目を越えるだけの品質を実現したいと思って取り組みました。

――リアルタイム制御にはどのような技術が用いられたのでしょうか。

大曽根 氏:弊社の持つモーションキャプチャ技術とリアルタイムCGキャラクタ制御技術を組み合わせた「BanaCAST」という技術を用いています。BanaCASTはモーションキャプチャデータをUnityやUE4、または内製ゲームエンジン等の描画エンジンにストリーミングし、それをもとに映像を生成するといったものです。「アイマスMR」の場合は他社製ゲームエンジンなどは使わず、すべて内製のライブラリで行っています。

佐々木 氏:モーションキャプチャ班からストリーミングで受け取ったモーションデータを、描画班がコントロールツールを通してレンダラーに送っています。コントロールツールもレンダラーも描画班がオリジナルで1から開発したものです。フェイシャルは汎用的なMIDIコントローラーを用いていますが、それらも含めてすべてリアルタイムに動いていますし、音声部分も解析の上で口の形を割り当てています。モーションとこれらの情報を統合したストリームを作成し送信するのがコントロールツールの役割です。その後は「ステラステージ」と同様の描画エンジンを用いて開発したレンダラーで、コントロールツールからのストリームを基に、フレームごとにアニメーションを割り当ててCGキャラクターの映像を生成するといった流れです。

――本家となるゲームと同じグラフィックスが目の前に現れるというのは非常にインパクトがあります。ライブイベントならではの技術的な取り組みや工夫があれば教えて下さい。特に、遅延の問題などはいかがでしたか?

佐々木 氏:アクターが動いてから、それがCGキャラクターのアニメーションとして反映されるまでの遅延は1フレーム(60分の1秒)以下です。普段からゲーム開発をしているからか、どうすれば低遅延かつ高フレームレートになるかを常に考えて作る癖が染みついておりまして、これが普通という感覚ですね。昔からナムコは何でも60fpsで動かすことへのこだわりが強いというか(笑)

大曽根 氏:レイテンシ周りで言えば、普通モーションキャプチャして映像生成するまでの間には大概ワンクッション何らかのソフトウェアがあることが多いらしいのですが、それを省いて直接ストリームに流す機能を実装しています。

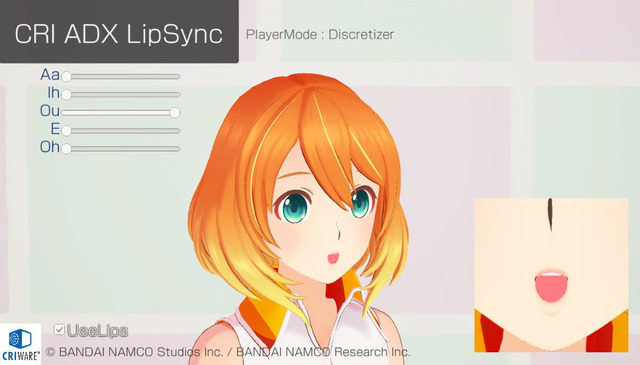

佐々木 氏:もともとの3Dモデルのレベルが非常に高く、激しいアクションにも対応できる仕組みでしたので、リアルタイムでも全く問題ありませんでした。ゲームとリアルタイムイベントの違いとして大きいのは、やはりリップシンク周りですね。キャラクターが喋っているときに、口がその通りに動かないとか、歌っているときのロングトーンで口が閉じてしまうといったことは「バグ」のように思われてしまうので、すべてリアルタイムだからこそリップシンク周りは気を使っています。ADX LipSyncは音声解析に必要な音声データ量がとても少なかったので、それも遅延の少なさに寄与していますね。

更なるクオリティを求めて「ADX LipSync」を導入

――ADX LipSyncの導入のきっかけを教えて下さい。

佐々木 氏:もともと2ndまでは内製のリップシンクシステムを用いて実装を行っていました。安定稼働していたので、出来るだけ変更しない越したことはないと思っていたのですが、CEDEC2019でADX LipSyncを拝見して「これはクオリティが高いな」と。これまでよりも精度が高く自然に見えるのであれば、ぜひ導入したいと考えました。

大曽根 氏:CRIさんはTGS2019でも弊社のキャラクター「ミライ小町」(※)を使ったデモをしていたかと思うのですが、個人的にすごく出来が良いと思っていて。佐々木が提案をしてきた時は「ああ、あれか!」とすぐに察しがつきました。

※(株)バンダイナムコスタジオのゲーム開発技術やバンダイナムコ研究所の未来に向けた技術研究を紹介するオリジナルキャラクター。

佐々木 氏:その後はSDKをご提供いただいて実装に取り掛かりましたが、内部のAPIもすごく素直で導入し易かったので、本当に1,2日で導入が出来てしまいました。その後もしばらく検証を続けて、内製よりも充分にメリットがあるなと感じましたので、正式に採用したんです。

――導入は非常にスムーズだったのですね。クオリティ以外の面で、佐々木さんが最も大きなメリットと感じた部分はどこですか?

佐々木 氏:先ほども申し上げた通り、解析に要求される音声データの量が少ないため遅延が短くなるというのが大きかったですね。ほかにも、パラメータが操作しやすかったのもありますし、「あいうえお」で抽出できるという日本語特化の仕組みも非常にマッチしていました。

大曽根 氏:私は中身までは理解していないのですが、これは様々な声質に対して細かい設定しなくても良い感じにリップシンクしてくれるという理解で良いんですか?

佐々木 氏:そうですね。以前に内製のリップシンクを使っていたときは演者さん全員分のあいうえおのサンプルの音を使って、それぞれに別々のパラメーターを用意して調整をしていましたが、 今回は細かい調整が不要でした。また、2ndまでは音量の差でも若干解析精度が変わってしまう癖があったため、普通の声量で話すMC中と大きな声で歌うときのレベル合わせが必要でしたが、 「ADX LipSync」は音量レベルで精度の差が出ないので、MCと歌唱パートとで設定を変えなくても良いところが助かりました。

――1st、2ndと内製ツールを使って安定していた中で、新たなツールを採用することは挑戦的なことだとも思います。リップシンクの重要性についてはどのように考えますか?

佐々木 氏:個人的には、『アイドルマスター』はただのゲームの世界ではなく、我々がリアルに生きているこの世界と良く似た別次元の世界であると考えています。そこで生きているアイドルたちを、画面を通して見ているという意識なんです。だから普通に滑らかに動くのはもちろんのこと、それに応じて口が動くのも「当たり前なこと」なんですね。その当たり前を実現するために、「ADX LipSync」を活用しました。

勝股 氏:話した通りに口が動くというのは、ユーザーからするとすでに普通のことという認識になってきています。そこに違和感を覚えてしまうと、会話そのものの偽物感に繋がってしまう。また、アイマスシリーズは生歌にこだわっていますが、声はしっかり届いてもモーションがついてこないと嘘っぽさが出てしまうんです。ロングトーンの部分で口を結んでしまうなどは完全に嘘をついていることになりますから、そういった部分を改善するために高精度なリップシンクは必須でした。

佐々木 氏:顔はどうしても注目されることが多いですからね。表情は喋っていることと多少異なっていたとしても違和感は少ないですが、喋ってるときに口が閉じていたり、逆に黙っているときに口がパクパクしていたら明らかにおかしいと感じてしまうので。

――実際に使ってみて、精度やクオリティ面は満足いく出来でしたか。

勝股 氏:細部の表現が以前よりも明らかに良くなったと思います。2ndまではリハーサルの時になかなか細部の表現が拾えなくて、私自身が操作卓に向かい、細かくオーダーをするようなことも良くあったのですが、今回はそれが全くなかった…というのも、ひとつ証拠になるのかなと(笑)

佐々木 氏:例えば「ばばばばば」という言葉は、一回一回「ば」と言うたびに口が一瞬閉じるのが自然ですが、解析上の母音は「あああああ」となりリップシンクの実装が難しいセリフです。

これに対してADX LipSyncでは「「あ」の強さ」みたいな情報を出してくれているので、その「強さ」も見て口を動かすようにすることで、比較的簡単に実現することが出来るようになりました。

CRIさんのサポート体制は非常に素晴らしく、SDKの対応も早いですしやりたいことに対する質問などのレスポンスも非常に速い。とても助かりましたね。

――最後に、『THE IDOLM@STER MR ST@GE!!』の今後の展開を教えて下さい。

勝股 氏:当初はクローズドから始まったMR ST@GE!!でしたが、携わるスタッフの皆様や技術力、なにより、プロデューサーの皆さんの支えで、ようやく自信をもって表に出せるところまで来ました。本当にありがとうございます。アイドルたちが現実世界で活躍できるステージを作りたいというコンセプトに対して、大きな一歩が踏み出せたと思っています。まだまだ可能性を秘めたコンテンツなので、ライブでもお芝居でも、まだまだ様々なことに挑戦したいと考えています。 今後もプロデューサーの皆さんの期待を越えたコンテンツを展開して行きます。

大曽根 氏:バンダイナムコグループには数多くのIPやさまざまなキャラクターがおりまして、彼らをこちら側の世界に「自然に居る」ようにしたいという想いは強かったんです。次元を越えるということを意識するまでもなく、自然に受け入れられるものを目指して頑張りたいと思っています。

佐々木 氏:家庭用ゲームの開発現場から見ると、ライブのように「お客さんの反応を直接見る」というのはとても貴重な体験なんですね。社内のスタッフも、お客さんの反応がリアルタイムで見られるのは楽しいと言っていて、それが開発の糧にもなっています。今後もこうした取り組みはぜひ続けていきたいですね。あと、技術的な部分では、そろそろ土台からシステム刷新をしたいと考えています。立ち止まっていてはすぐに周りに追い越されてしまうので、常に進歩し続けていきたいと思います。

――ありがとうございました。

CRI ADX LipSyncは、ディープラーニングによる音声解析技術を活用し、音声データから自然な口パターンを自動生成する音声解析リップシンクミドルウェアです。ゲーム内の会話シーンやバーチャルキャラクターのライブ配信などで、セリフに合わせた自然な口の動きを生成します。詳しくは「音声解析リップシンクミドルウェア CRI ADX LipSync」をご覧ください。

CRI ADX LipSyncは、ディープラーニングによる音声解析技術を活用し、音声データから自然な口パターンを自動生成する音声解析リップシンクミドルウェアです。ゲーム内の会話シーンやバーチャルキャラクターのライブ配信などで、セリフに合わせた自然な口の動きを生成します。詳しくは「音声解析リップシンクミドルウェア CRI ADX LipSync」をご覧ください。